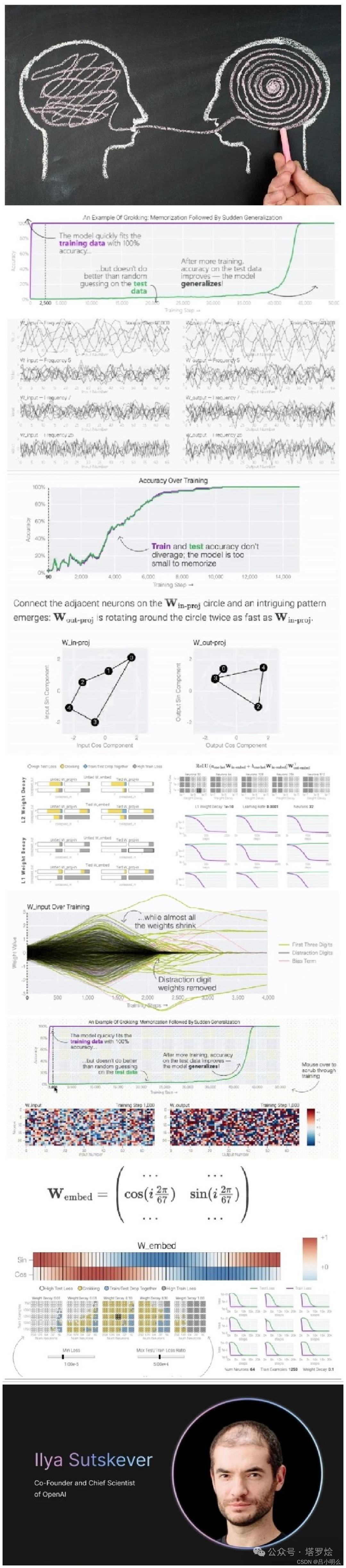

搞清楚模型对知识或模式的学习与迁移对于泛化意味什么,或者说两者间的本质?相信大家对泛化性作为大语言模型LLM的突出能力已经非常了解了 - 这也是当前LLM体现出令人惊叹的通用与涌现能力的基础前提,这里不再过多赘述,但仍希望大家对泛化能力本身结合特定领域问题进行更延展而深邃的思考,即我们对于泛化本身了解多少?泛化能力是否具备天然分层的特性?泛化本身在真实世界各领域中是否存在一定的结构特异性,即跨不同领域间进一步进行泛化迁移的可能与路径..当前llm的成功或体现出令人惊艳的涌现能力我想对于这种大规模无监督学习以及AR下的next token prediction并非偶然,一定亦是那些先行者洞察到了其中的某些关键要素与内涵后通过不断尝试与实践gradient descent而来的,是的,也许人们的大脑中内置了更加具备泛化的lost function也说不定,就像Ilya去年在伯克利上在无监督学习领域中引入的Kolmogorov(K氏复杂度)、模型对数据压缩的解释以及从条件建模到联合建模压缩的阐释,当然大家也可以回顾之前的几篇笔记,如上一篇「笔记Ⅳ」中的一些洞察和角度...

因此,我想在更多充分的掌握了对于泛化本身更深层次的了解或者仅仅是直觉上的感知也好,在未来针对更复杂的认知模式探索过程中对于模型所采用的训练模式、学习任务、计算方法等将会有着非常重要的指导作用,说不定哪天谁又会带来一些新的炸裂的事情呢?~

下面放一段Ilya去年在伯克利上上演讲的一段话,大家可以体会下:)↓

“ 这种联合压缩的思想,才是无监督学习的真正威力所在。因为现实世界的数据往往是相互关联的,存在大量的深层共同模式和规律。如果我们能够用无监督学习去发现和利用这些规律,就能极大地提高学习的效率和泛化能力。”

)

)