CNN 和 Transformer 是深度学习中两种强大的模型,它们各自在图像处理和自然语言处理领域取得了巨大成功。将这两种模型融合起来,可以创造出一种新型的架构,以利用 CNN 在空间特征提取方面的优势和 Transformer 在处理序列数据方面的能力。

沃的顶会汇总了36种【CNN与Transformer融合】创新路径,希望给各位的学术研究提供一些帮助。

最新融合创新方案

#01 HAFormer

| 融合 CNN 与 Transformer 的高效轻量级语义分割模型

论文标题:Unleashing the Power of Hierarchy-Aware Features for Lightweight Semantic Segmentation

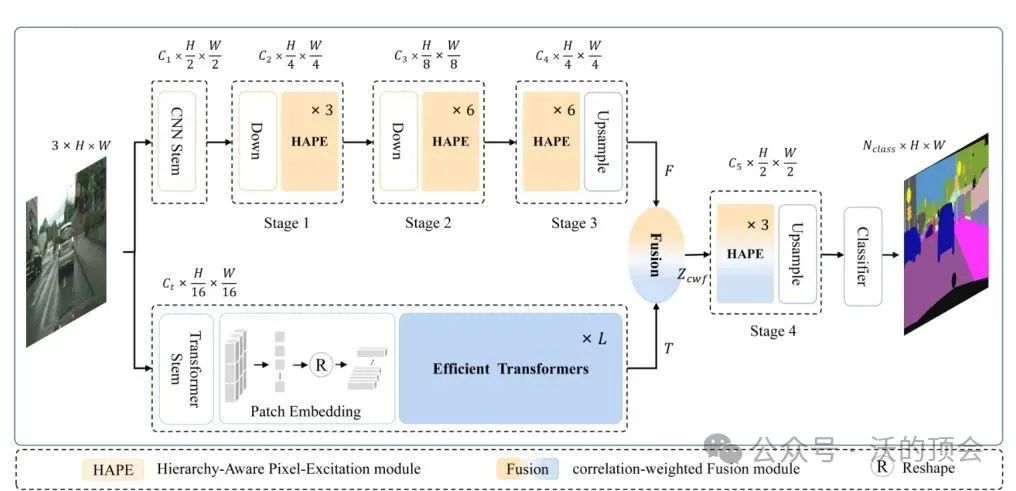

方法:本文提出了HAFormer模型,该模型结合了CNN的分层特征提取能力与Transformer的全局依赖建模能力,以应对轻量级语义分割挑战。HAFormer的整体架构包括三个组件:一个带有层次感知像素激活增强的CNN编码器,一个高效的Transformer编码器,以及一个轻量级的解码器。

创新点:

1)提出了一种新颖的分层感知像素激活(HAPE)模块,利用分层和内容感知注意力机制来减少计算负担,同时从各种感受野下的像素中提取更深的语义信息。

2)开发了一种有效的特征融合机制,名为相关加权融合(cwF),以协同整合由CNN和Transformer学习的局部和全局上下文特征,有效提高准确度。

3)提出了一种有效的Transformer,分解,和矩阵,有效地解决了传统Transformer模型中的二次计算复杂性挑战。

需要的同学添加公众号【沃的顶会】 回复 CT36 即可全部领取

#02 GlocalFuse-Depth

| 融合CNN与Transformer,实现全天候自监督单目深度估计

论文标题:Unleashing the Power of Hierarchy-Aware Features for Lightweight Semantic Segmentation

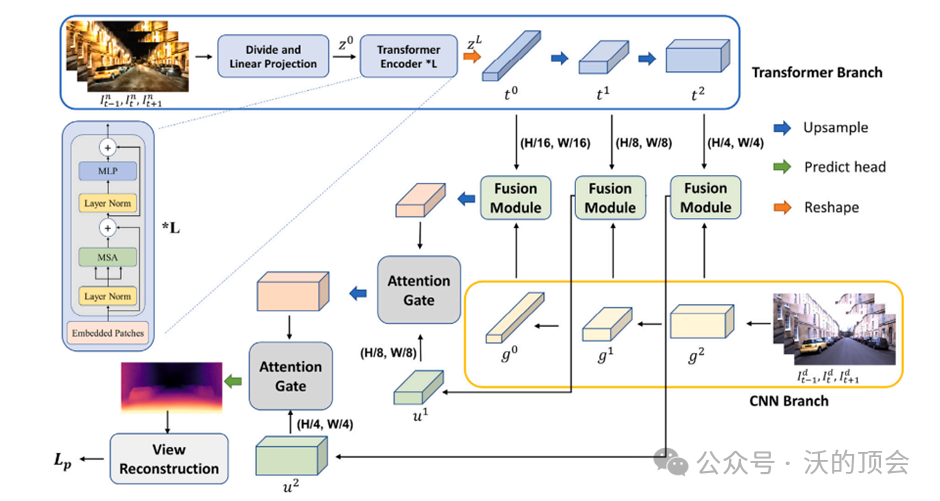

方法:本文提出了一种基于Transformer和CNN融合的全天候自监督深度估计神经网络:GlocalFuse-Depth,其包含两个分支,分别处理包含相同深度信息的白天和夜晚图像。同时,Transformer和CNN 被用作两个分支的编码器以捕获局部和全局特征。而后,具有相同维度的特征被融合,用于预测深度。

创新点:

1)提出了一种双分支网络GlocalFuse-Depth,用于自监督的全天图像深度估计。它采用互补的编码器(CNN和Transformers)捕捉局部和全局信息的昼夜图像对,以更好地把握RGB图像和深度图之间的纹理对应。

2)GlocalFuse-Depth是第一个用于全天图像深度估计的CNN和Transformer融合模型。

3)提出了一种新的融合模块,它将来自两个分支的信息进行组合和聚合,以获得最终的深度估计的全面表示,同时应用通道和空间注意来增强我们两个分支网络的表示能力。

需要的同学添加公众号【沃的顶会】 回复 CT36 即可全部领取

#03 ParaTransCNN

| 融合的CNN和Transformer的医学图像分割并行编码器

论文标题:ParaTransCNN: Parallelized TransCNN Encoder for Medical Image Segmentation

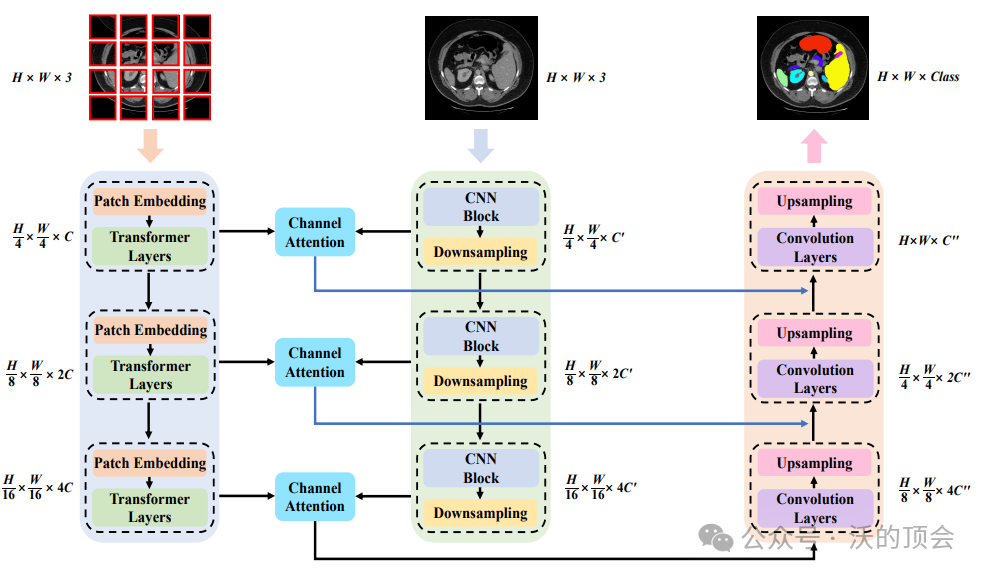

方法:本文提出了一种用于医学图像分割的并行编码器模型。与仅依赖单个编码器分支集成图像全局和局部信息的传统分割模型不同,该方法包括两个独立的分支,它们分别从输入图像中捕获语义信息。ParaTransCNN 的整体架构遵循与 U-Net 类似的编码器-解码器范式,由编码器、通道注意力模块、跳跃连接和解码器组成。并行编码器结合了ResNet和Transformer的优势,充当骨干网络。在Transformer组件中,引入了一个金字塔结构,用于以多种分辨率捕获全局特征。此外,采用信道注意模块来增强并行编码器的表达能力,丰富提取的特征,并为后续的解码过程提供全面的指导。我们还利用跳过连接和解码器模块来估计最终的分割掩码。

创新点:

1)提出了ParaTransCNN网络,一个U形的医学图像分割架构,融合的CNN和Transformer组成的并行编码器。我们的编码器可以提取不同维度的局部和全局特征并对其进行高效的映射,为解码器提供丰富的像素级语义信息。

2)Transformer分支引入了金字塔结构来学习不同尺度的全球信息,而CNN分支使用相同的降采样策略来学习局部信息。为了实现高效的多尺度特征融合,设计了一个通道注意模块,激活有用的通道特征,抑制不必要的特征。

)

)