NVIDIA Hopper GPU 架构(2分钟了解英伟达)

为新一代工作负载打造的加速计算平台。

NVIDIA Hopper架构是一种新一代GPU技术,它在性能、效率和扩展性方面均有着显著的优势。该架构可安全扩展每个数据中心的各种工作负载,让出色的创新者能够以人类历史上更快的速度完成工作。Hopper 架构可为加速计算实现新的巨大飞跃,从小型企业到百亿亿次级高性能计算 (HPC) 和万亿参数的 AI,Hopper 架构均可应对 。

准备好迎接企业 AI 了吗?

搭载NVIDIA H100 Tensor Core GPU的主流服务器,搭配NVIDIA AI Enterprise软件套件,助力AI应用轻松上手,性能卓越。

探索技术突破

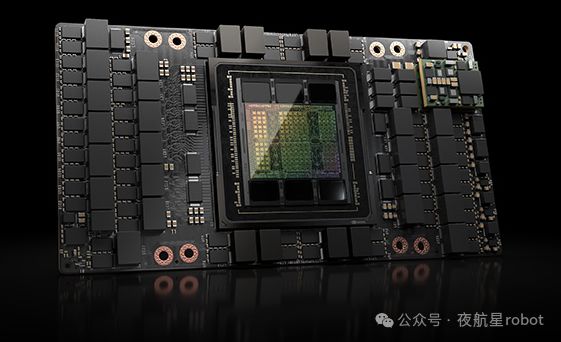

"Hopper,凭借台积电4N制造工艺打造,拥有超过800亿晶体管的规模,为NVIDIA H200和H100 Tensor Core GPU注入强大动力。五项创新技术使其在生成式AI训练与推理方面实现了显著速度提升,超越了前代产品。"

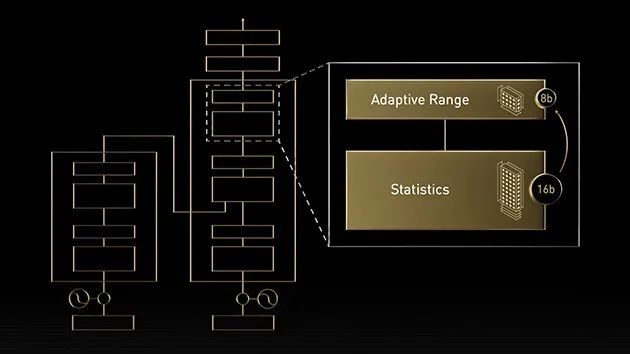

Transformer 引擎

NVIDIA Hopper 架构通过 Transformer 引擎推进 Tensor Core 技术的发展,旨在加速 AI 模型训练。Hopper Tensor Core 能够应用混合的 FP8 和 FP16 精度,以大幅加速 Transformer 模型的 AI 计算。与上一代相比,Hopper 还将 TF32、FP64、FP16 和 INT8 精度的每秒浮点运算 (FLOPS) 提高了 3 倍。Hopper Tensor Core 与 Transformer 引擎和第四代 NVIDIA® NVLink® 相结合,可使 HPC 和 AI 工作负载的加速实现数量级提升。

NVLink、NVSwitch 和 NVLink Switch 系统

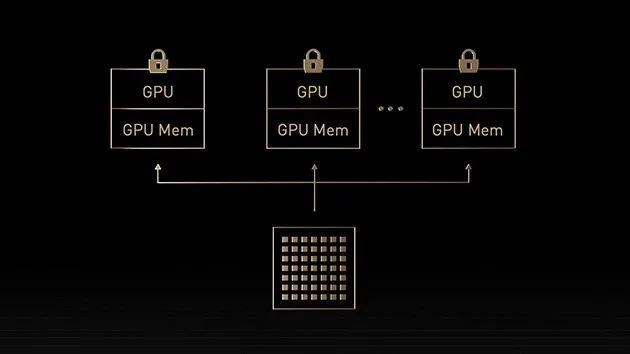

为了应对业务活动的高速需求,我们需要在百亿亿次级HPC和万亿参数的AI模型之间实现GPU间流畅高速通信,以实现大规模加速。

第四代NVLink技术,通过NVIDIADGX和HGX服务器,可以扩展多GPU输入和输出(IO),每个GPU的双向传输速率可达900GB/s,比PCIe5.0带宽高7倍。

第三代 NVIDIA NVSwitchTM 支持 SHARPTM 网络计算技术,打破了该技术只能通过 InfiniBand 提供的传统。此外,八卡 H200 或 H100 GPU 服务器与上一代 A100 Tensor Core GPU 系统相比,all-reduce 吞吐量增加了两倍。

第三代 NVIDIA NVSwitch 旨在为 NVLink 交换机 系统提供节点内或节点外部 GPU 的连接。 它还将 硬件 加速与多播和 NVIDIA 可扩展分层 聚合 和缩减协议( SHARP ) 在 网络 缩减中。 NVIDIA NVSwitch 也是 NVLink 开关 网络设备 ,允许创建最多连接 256 个的群集 NVIDIA H100 Te ns or Core GPUs 以及 57.6TB / s 的全对全带宽。 与 NVIDIA 安培架构 GPU 上的 HDR InfiniBand 相比,该设备可提供 9 倍的二等分带宽。

"DGX GH200,搭载NVLink Switch技术,能构建由256个H200设备相互连接的集群。其惊人的带宽性能达到57.6TB/s,实现all-to-all的高速数据传输。"

在过去的十年里,我国的互联网用户数量已经增长了超过7倍,达到了9亿人。其中,手机网民占比达到了90%。这些数据表明,互联网在我国已经成为了人们日常生活中不可或缺的一部分。

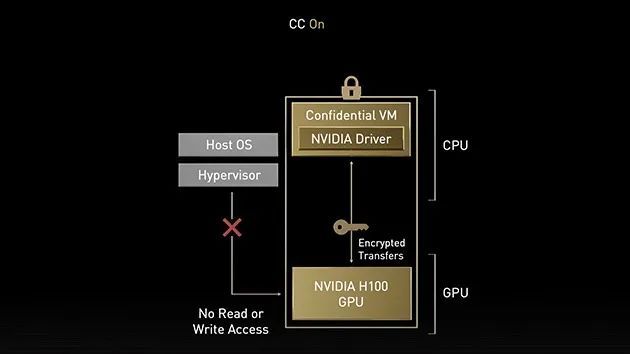

NVIDIA 机密计算

NVIDIA Hopper 架构是 NVIDIA 推出的一项突破性安全功能,可缓解数据处理期间的威胁。该架构引入了具有机密计算功能的加速计算平台,通过保护使用中的数据和应用来弥合这一差距。

凭借强大的基于硬件的安全性,用户可以在内部、云端或边缘运行应用,并确保未经授权的实体在使用时无法查看或修改应用代码和数据。这一方面能够保护数据和应用的机密性和完整性,另一方面在用于 AI 训练、推理和 HPC 工作负载时可以实现 H200 和 H100 GPU 的大幅加速。

第二代 MIG

借助多实例 GPU (MIG),GPU 可以分割成多个较小的、完全独立的实例,并拥有自己的内存、缓存和计算核心。Hopper 架构通过多达 7 个 GPU 实例在虚拟化环境中支持多租户、多用户配置,进一步增强了 MIG,在硬件和管理程序级别使用机密计算安全地隔离每个实例。

借助每个 MIG 实例的专用视频解码器,在共享基础架构上提供安全、高吞吐量的智能视频分析 (IVA)。此外,借助 Hopper 架构的并发 MIG 分析,管理员可以监控合适规模的 GPU 加速,并为用户优化资源分配。

对于研究任务不繁重的工作者,无需投入完整的云服务资源。MIG可帮助您安全地分配部分GPU资源,确保数据在静止、传输和计算过程中的安全。

DPX 指令

动态编程是一种算法技术,通过将复杂递归问题分解为更简单的子问题来解决。通过存储子问题的结果,您之后也不必重新计算它们,从而减少了指数级问题解决的时间和复杂性。动态编程常用于各种用例。例如,Floyd-Warshall 是一种路线优化算法,可用于绘制运输和配送车队的最短路线;Smith-Waterman 算法可用于 DNA 序列比对和蛋白质折叠应用 。

Hopper 架构通过引入 DPX 指令,将动态编程算法速度提升至 CPU 的 40 倍,相较于 NVIDIA 前一代 Ampere 架构 GPU,更是提高了 7 倍。这一突破性进展极大地加速了疾病诊断、实时路由优化以及图形分析等领域的速度。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-