目录

Ollama 是一个能在本地机器上轻松构建和运行大型语言模型的轻量级、可扩展框架,适用于多种场景,具有易于使用、资源占用少、可扩展性强等特点。

1.安装下载ollama

2.为 Ollama 创建一个用户

3.为ollama创建服务文件

4.启动ollama服务

5.拉取语言模型镜像

(1) pull一个语言模型

(2) 查看本地模型

(3) 本地运行测试模型

Ollama 是一个能在本地机器上轻松构建和运行大型语言模型的轻量级、可扩展框架,适用于多种场景,具有易于使用、资源占用少、可扩展性强等特点。

官网地址:https://ollama.com/

中文地址:https://ollama.fan/getting-started/

1.安装下载ollama

curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama##如果拉取失败可以使用浏览器访问下载上传至服务器的/usr/bin/目录并名称改为ollama

chmod +x /usr/bin/ollama2.为 Ollama 创建一个用户

useradd -r -s /bin/false -m -d /usr/share/ollama ollama3.为ollama创建服务文件

cat <<EOF>> /etc/systemd/system/ollama.service[Unit] Description=Ollama ServiceAfter=network-online.target[Service]Environment="OLLAMA_HOST=0.0.0.0:11434" ###默认只能本地回环地址可访问,添加此行所有地址均可访问ExecStart=/usr/bin/ollama serveUser=ollamaGroup=ollamaRestart=alwaysRestartSec=3[Install]WantedBy=default.targetEOF4.启动ollama服务

#重新加载服务文件,启动并设置开机自启systemctl daemon-reloadsystemctl enable ollama --now#到这里ollama就安装完成了!

5.拉取语言模型镜像

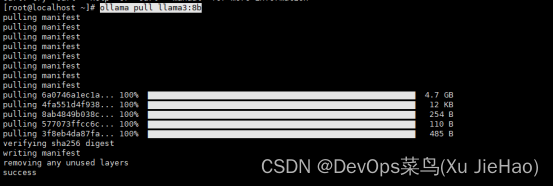

(1) pull一个语言模型

ollama pull qwen:0.5b#由于模型镜像比较大拉取速度可能会有一些慢大概需要半个小时,当然速度取决于网速

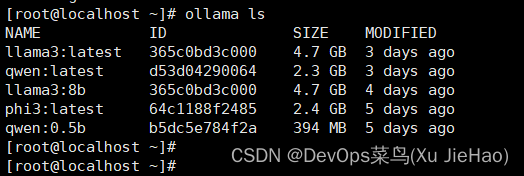

(2) 查看本地模型

ollama list

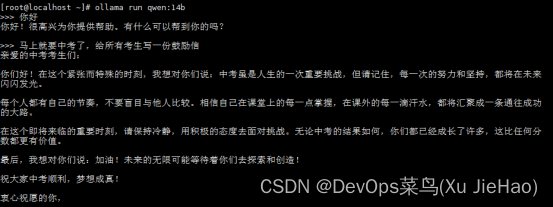

(3) 本地运行测试模型

ollama run qwen:0.5b#进入交互界面随便问一些问题

>>> 马上就要中考了,给所有考生写一份鼓励信

##CPU/GPU的性能越高模型响应速度越快