文章目录

- 前言

- 1. 本地部署Llama3.1

- 2. 本地安装LobeChat可视化UI界面

- 3. 在LobeChat中添加Llama3.1

- 4. 安装Cpolar内网穿透

- 5. 实现公网访问LobeChat

- 6. 固定LobeChat公网地址

前言

如果你对自然语言处理、机器学习或者 AI 有兴趣,那今天分享的如何把强大的 Llama3.1 大模型安装到本地,并通过 LobeChat 的可视化界面实现公网远程访问详细操作绝对不容错过!

Llama3.1 是一款开源的语言模型,它不仅支持八种不同的语言,还具备通用知识、数学计算能力以及多语言翻译和工具使用功能。想象一下,在你的电脑上运行这样一个强大的工具会有多么震撼吧!而且,通过 LobeChat 的可视化用户界面,你可以直接在网页上与这个智能模型进行互动。

接下来的内容将会手把手教你如何完成这一过程。无论你是技术小白还是资深开发者,都能轻松掌握这些步骤。让我们一起开启这场科技之旅吧!

【视频教程】

Windows系统电脑本地部署Llama3.1AI大模型并实现异地远程使用

1. 本地部署Llama3.1

本地电脑硬件要求:

Windows:3060以上显卡+8G以上显存+16G内存,硬盘空间至少20G

Mac:M1或M2芯片 16G内存,20G以上硬盘空间

本篇文章测试环境:Windows10专业版

首先需要安装Ollama客户端,来进行本地部署Llama3.1大模型

下载地址:https://ollama.com/download

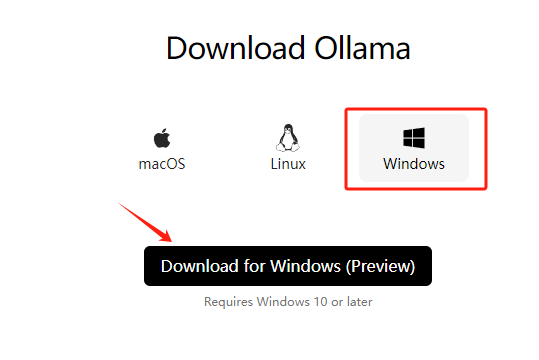

在下载页面点击Windows,然后点击下载按钮。

下载完成后,双击下载的安装程序。

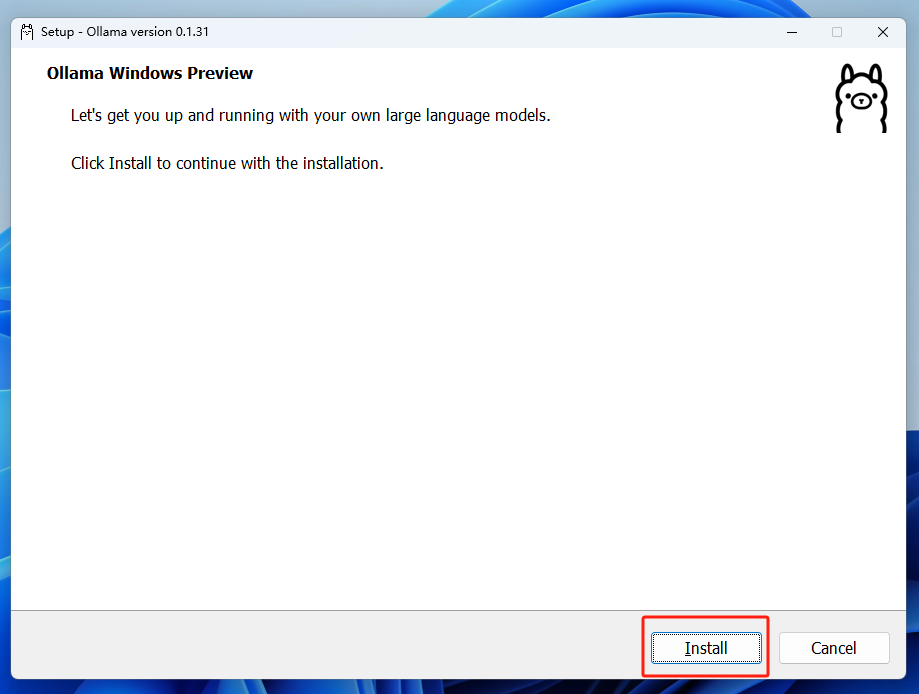

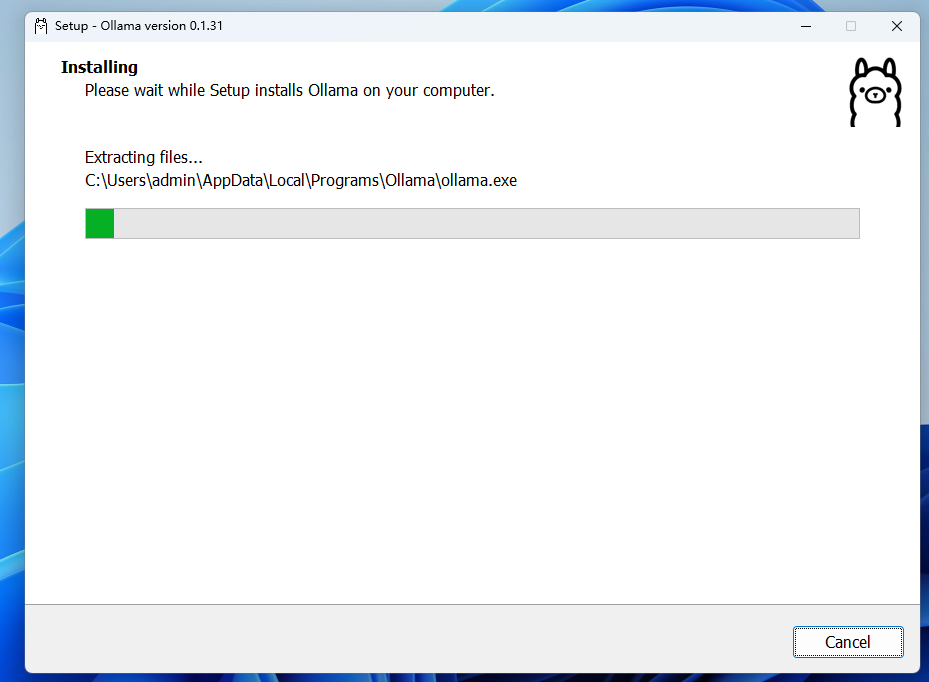

点击Install进行安装。

安装完成后,双击ollama客户端自动打开Windows Power Shell,如果没有自动弹出,也可以手动打开cmd,这里打开cmd为例:

我们在终端中输入ollama,它会显示出当前这款ollama程序,它的使用及安装命令

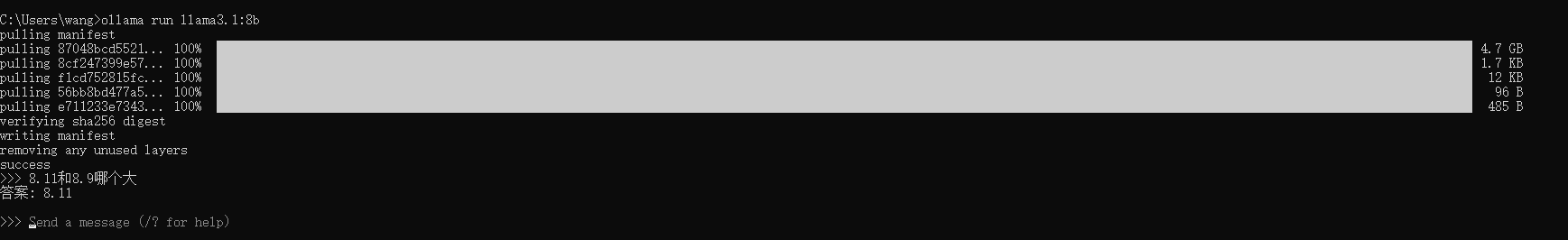

接下来继续在终端中安装Llama3.1-8b(至少需要8G显存)

ollama run llama3.1:8b

上方显示已安装成功,接下来就可以进行使用了,比如这里可以在终端中输入问题

我们已经成功的在本地部署了Llama3.1,但是只能在终端中来使用,如果能使用web界面进行交互,使用体验会更好,也可以保留之前的聊天记录,方便查找和使用,下面带大家安装LobeChat可视化UI界面!

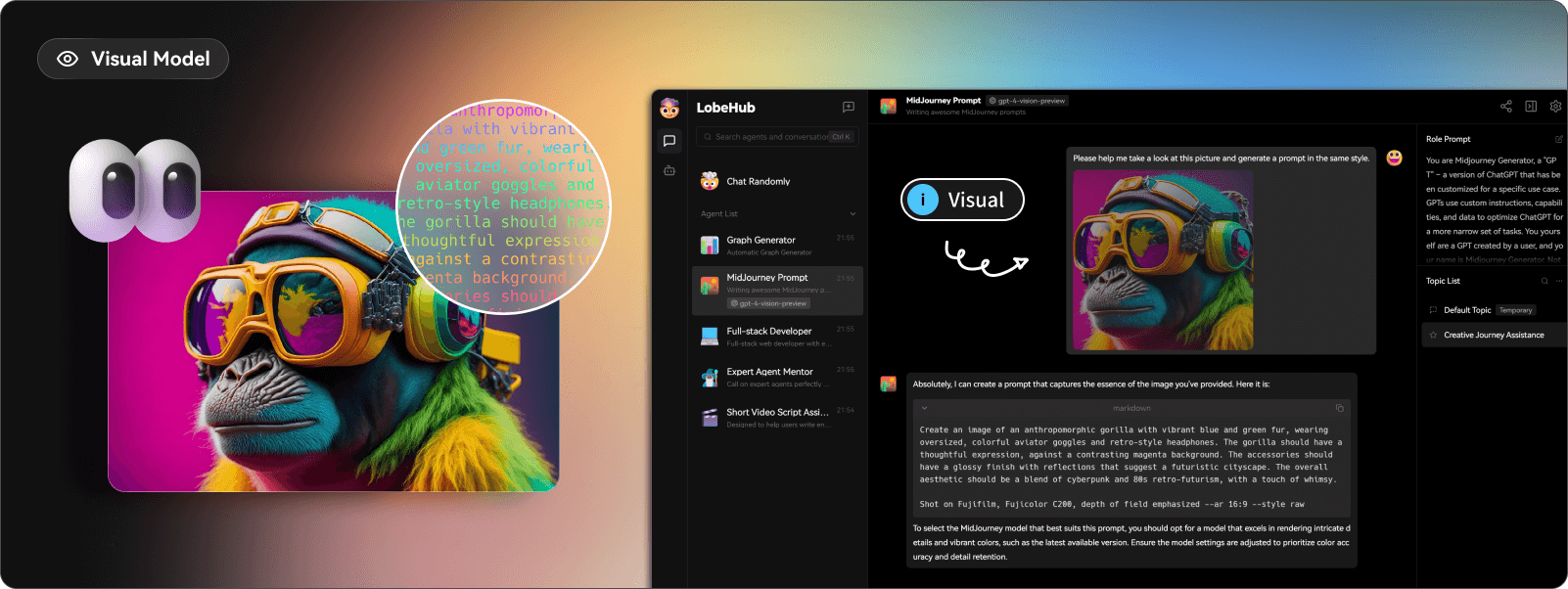

2. 本地安装LobeChat可视化UI界面

Lobe Chat作为一款开源、现代化设计的聊天应用,具有许多令人青睐的特点和功能,接下来教大家如何在本地安装LobeChat。

**官网地址:**https://lobehub.com/zh

**GitHub地址:**https://link.zhihu.com/?target=https%3A//github.com/lobehub/lobe-chat

本地安装流程:

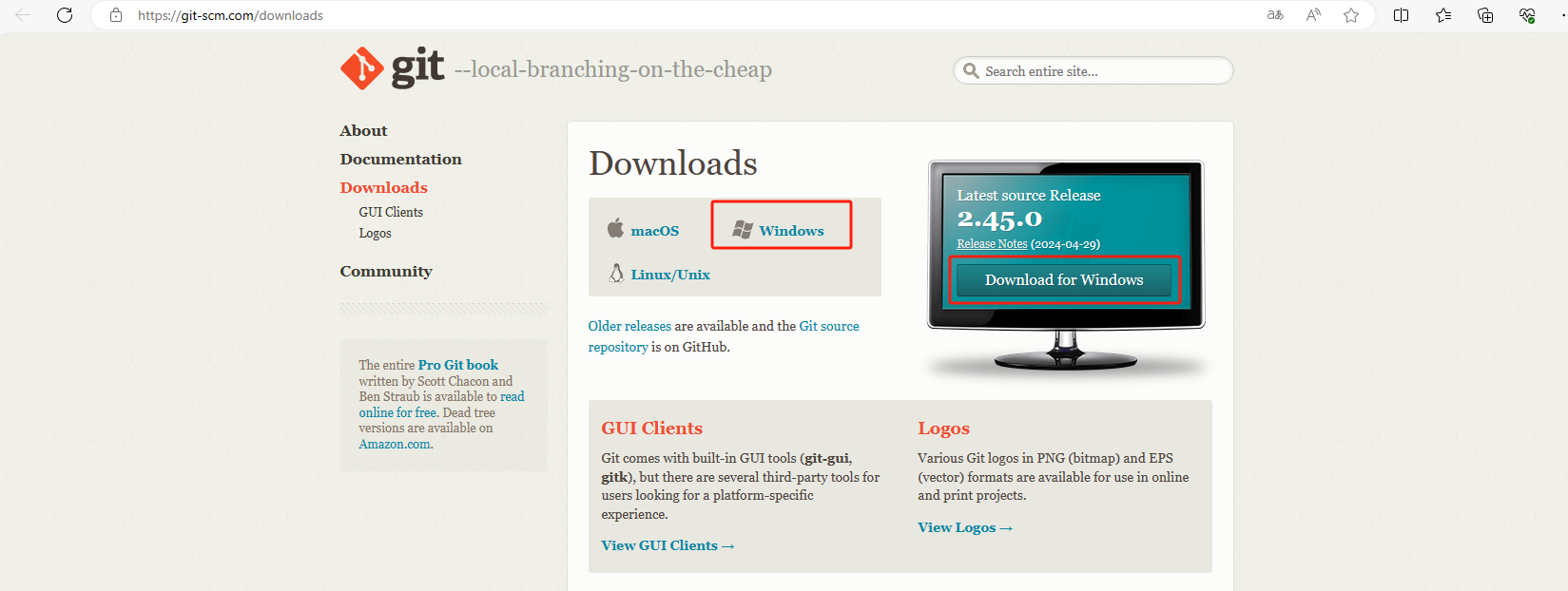

首先从github上克隆lobechat(如果没有安装git的话,进入git官网进行下载windows版本 https://git-scm.com/downloads)

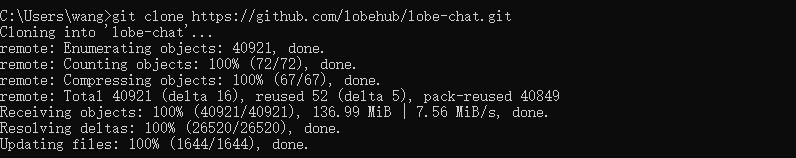

打开命令行,从github下载项目到本地,执行下面的命令

git clone https://github.com/lobehub/lobe-chat.git

创建新目录

cd lobe-chat

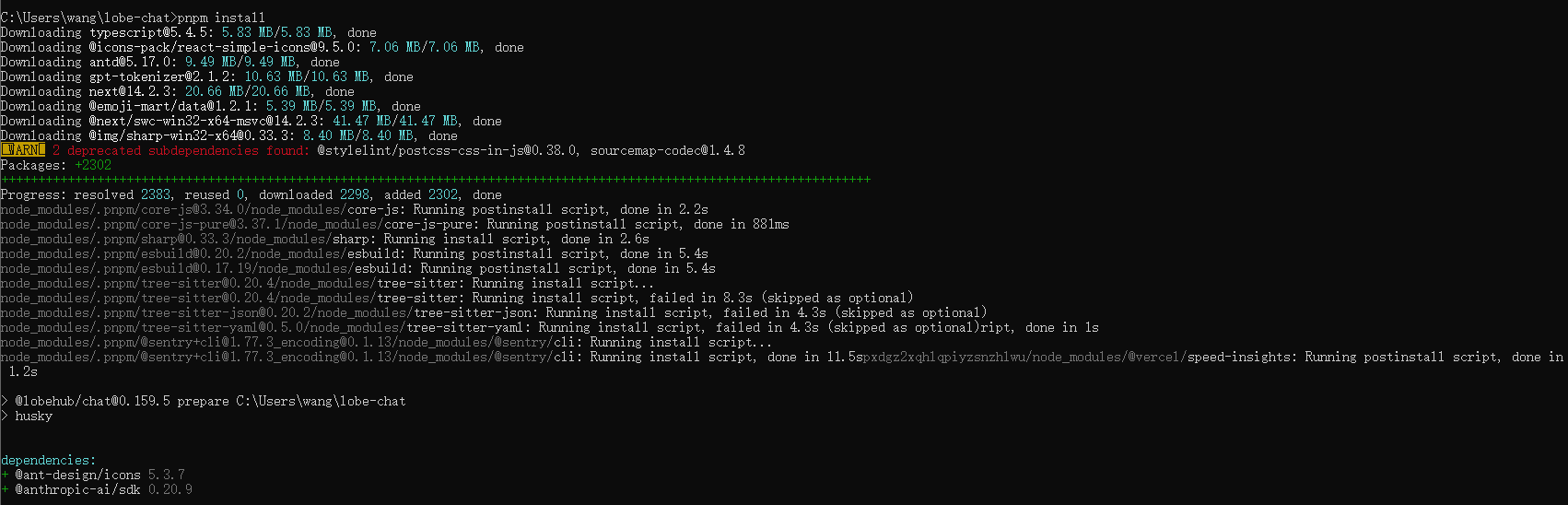

在项目的根目录下,执行下面的命令,下载依赖。

pnpm install

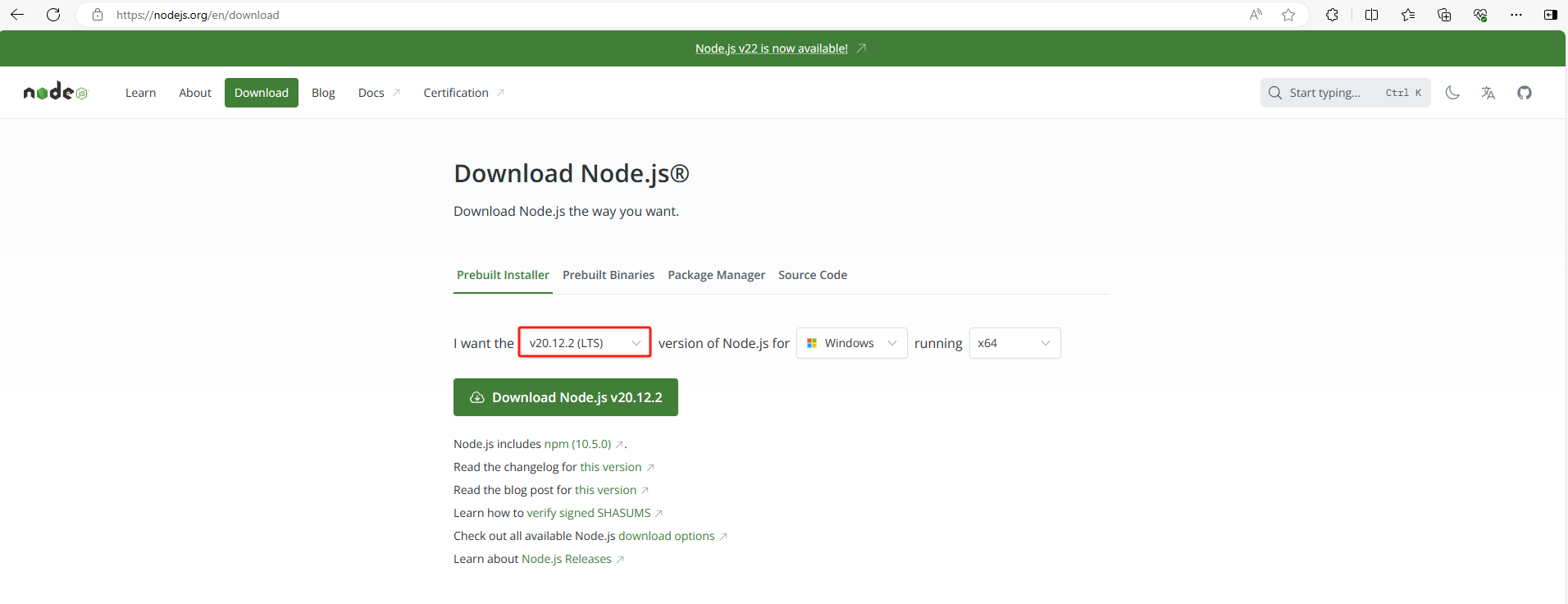

(注意:没有安装Node.js的话,点击官网下载链接https://nodejs.org/en/download,这里演示版本是v20.12.2)

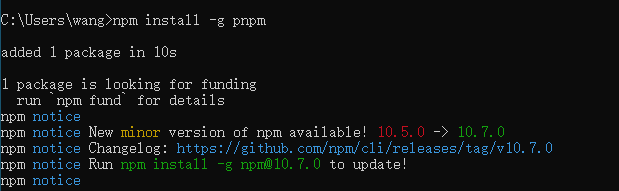

(注意:如果未安装pnpm,需要使用下方代码一键安装pnpm)

npm install -g pnpm

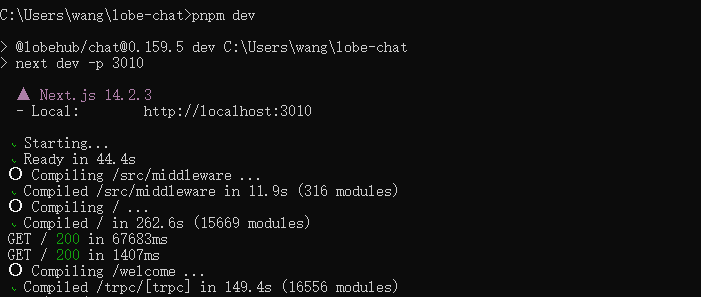

在项目的根目录下,运行LobeChat,可以看到运行成功,出现http://localhost:3010

pnpm dev

3. 在LobeChat中添加Llama3.1

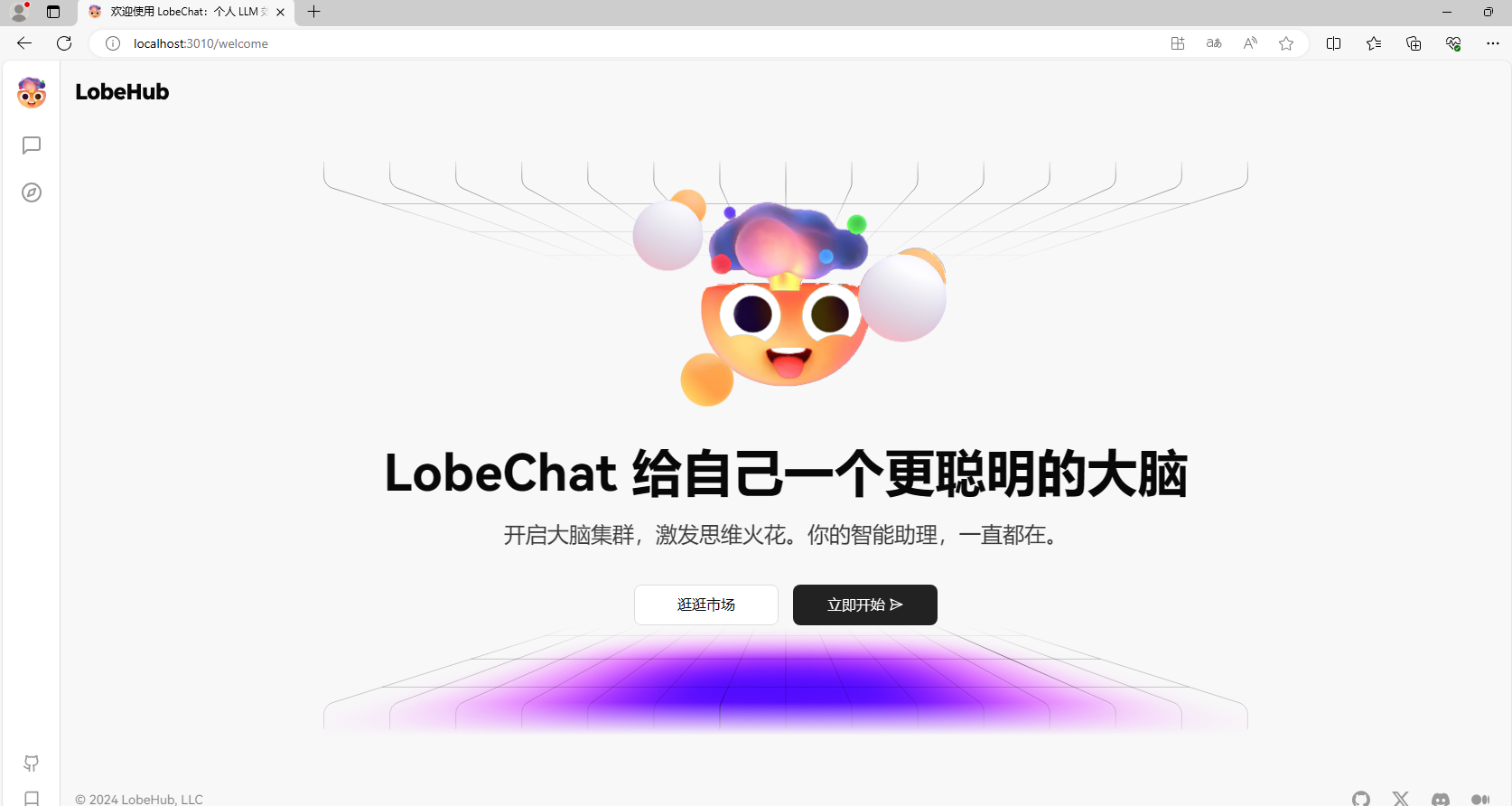

可以看到我们已经在本地部署了LobeChat,测试一下是否部署成功打开新的浏览器输入:http://localhost:3010

可以看到进入到了LobeChat的主界面

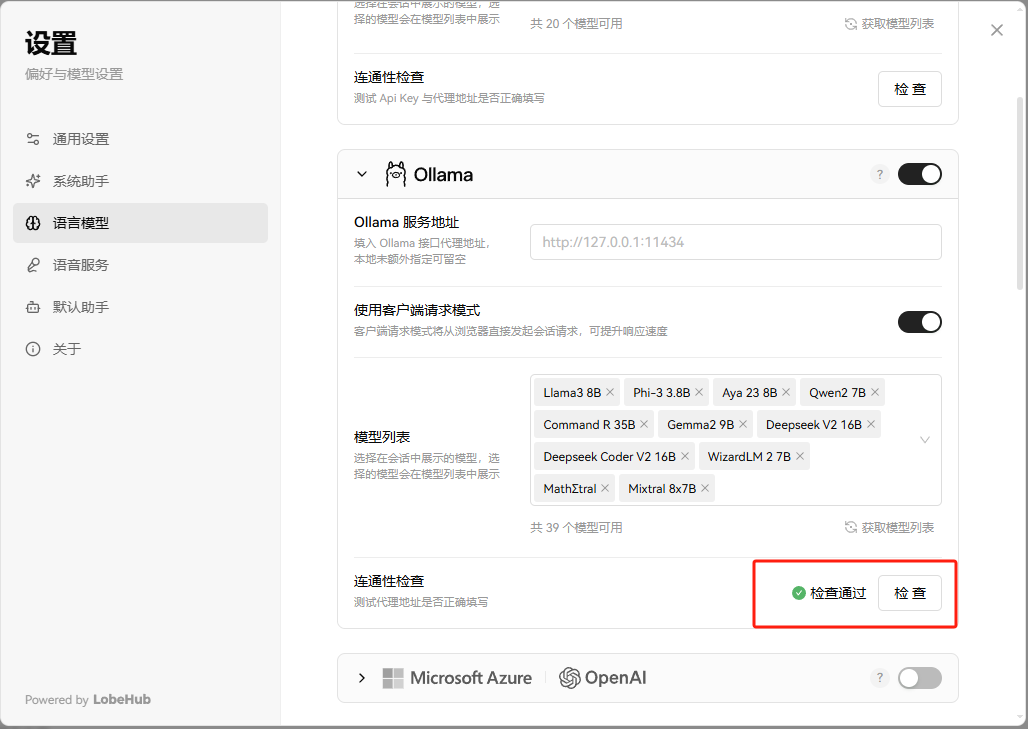

- 点击左上角头像,找到设置,选择语言模型,找到Ollama,开启它,并做连通性检查 。

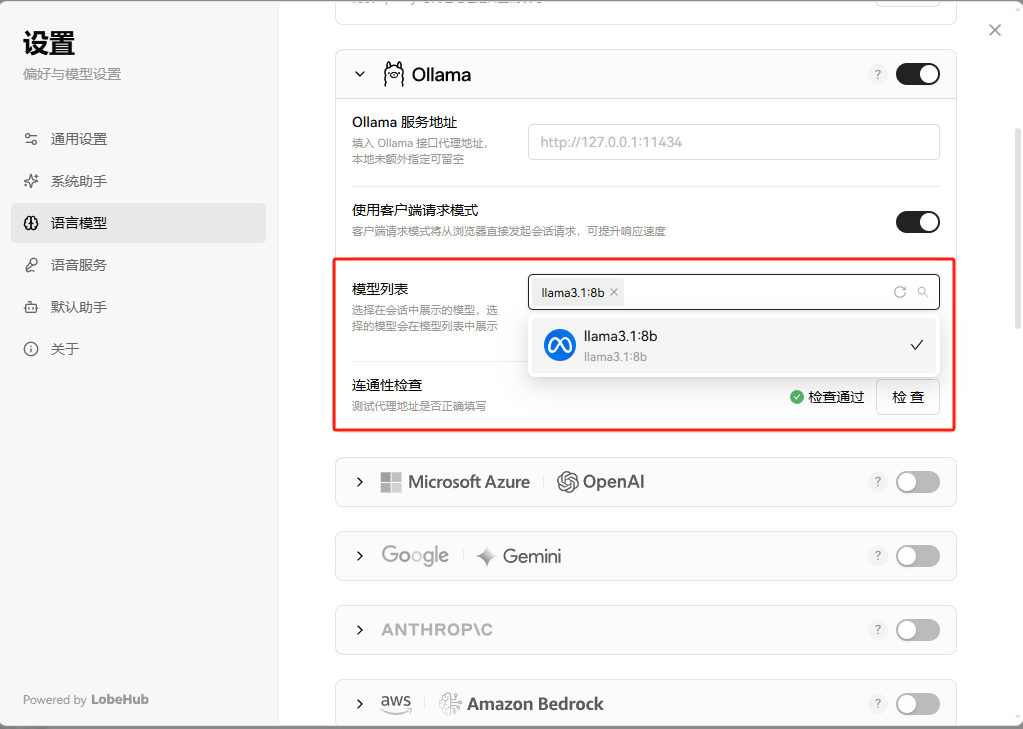

- 检查通过,获取模型列表

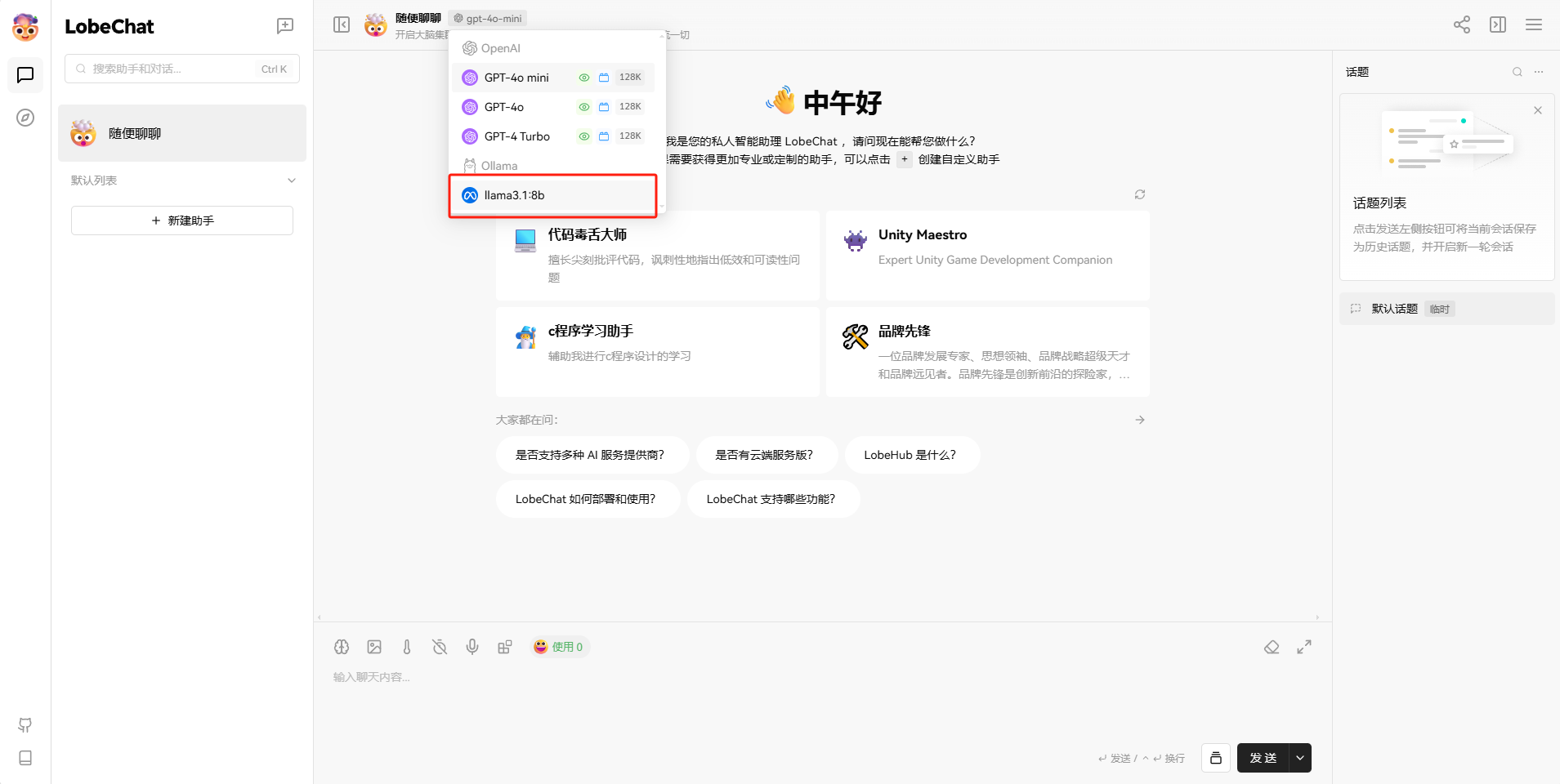

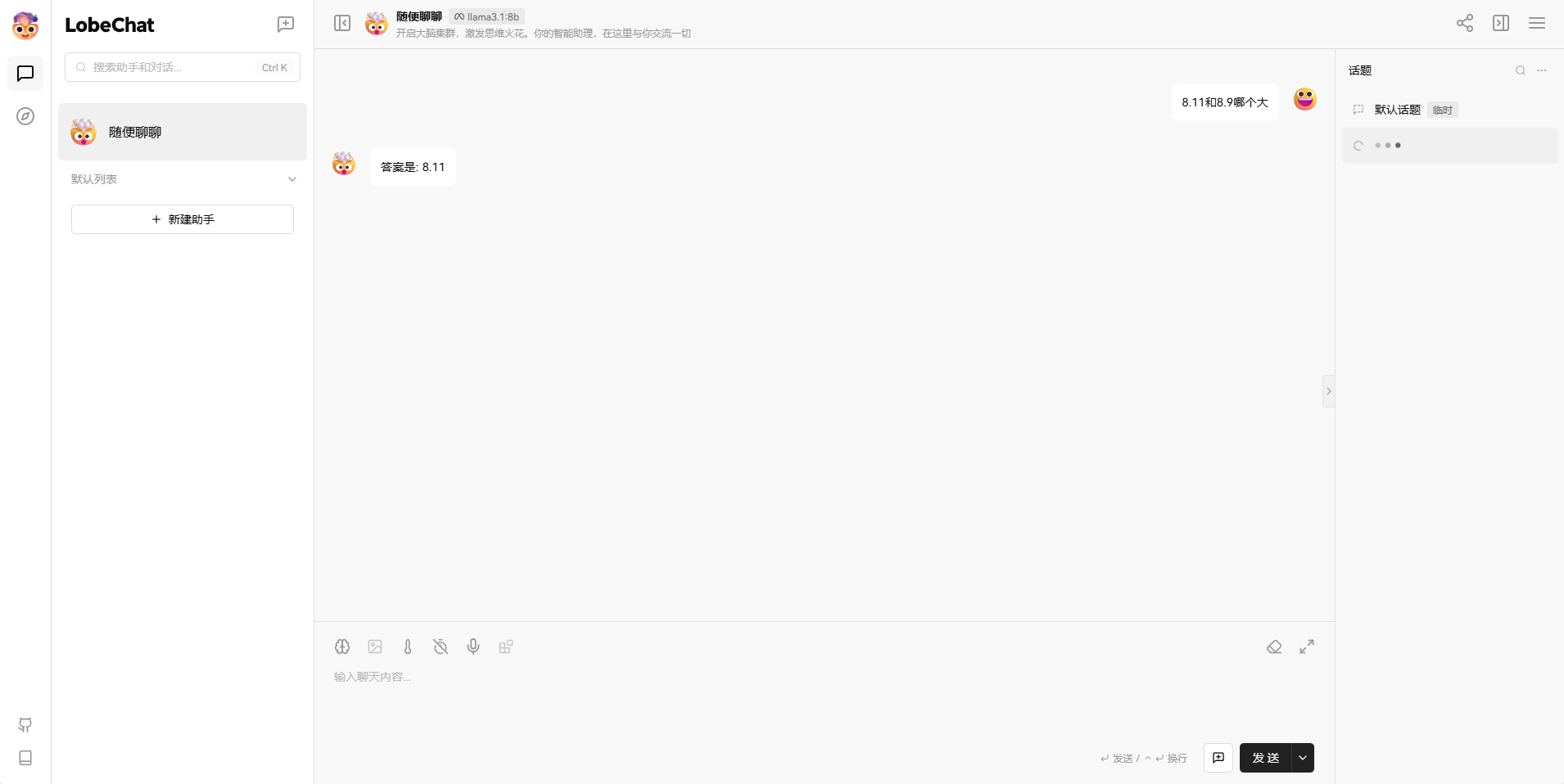

- 回到聊天窗口,选择llama3.1:8b模型

接下来就可以进行聊天了。

目前我们在本机部署了LobeHub,并且还添加了Llama3.1大模型,如果想团队协作多人使用,或者在异地其他设备使用的话就需要结合Cpolar内网穿透实现公网访问,免去了复杂得本地部署过程,只需要一个公网地址直接就可以进入到LobeChat中。

接下来教大家如何安装Cpolar并且将LobeChat实现公网访问。

4. 安装Cpolar内网穿透

下面是安装cpolar步骤:

Cpolar官网地址: https://www.cpolar.com

点击进入cpolar官网,点击免费使用注册一个账号,并下载最新版本的Cpolar

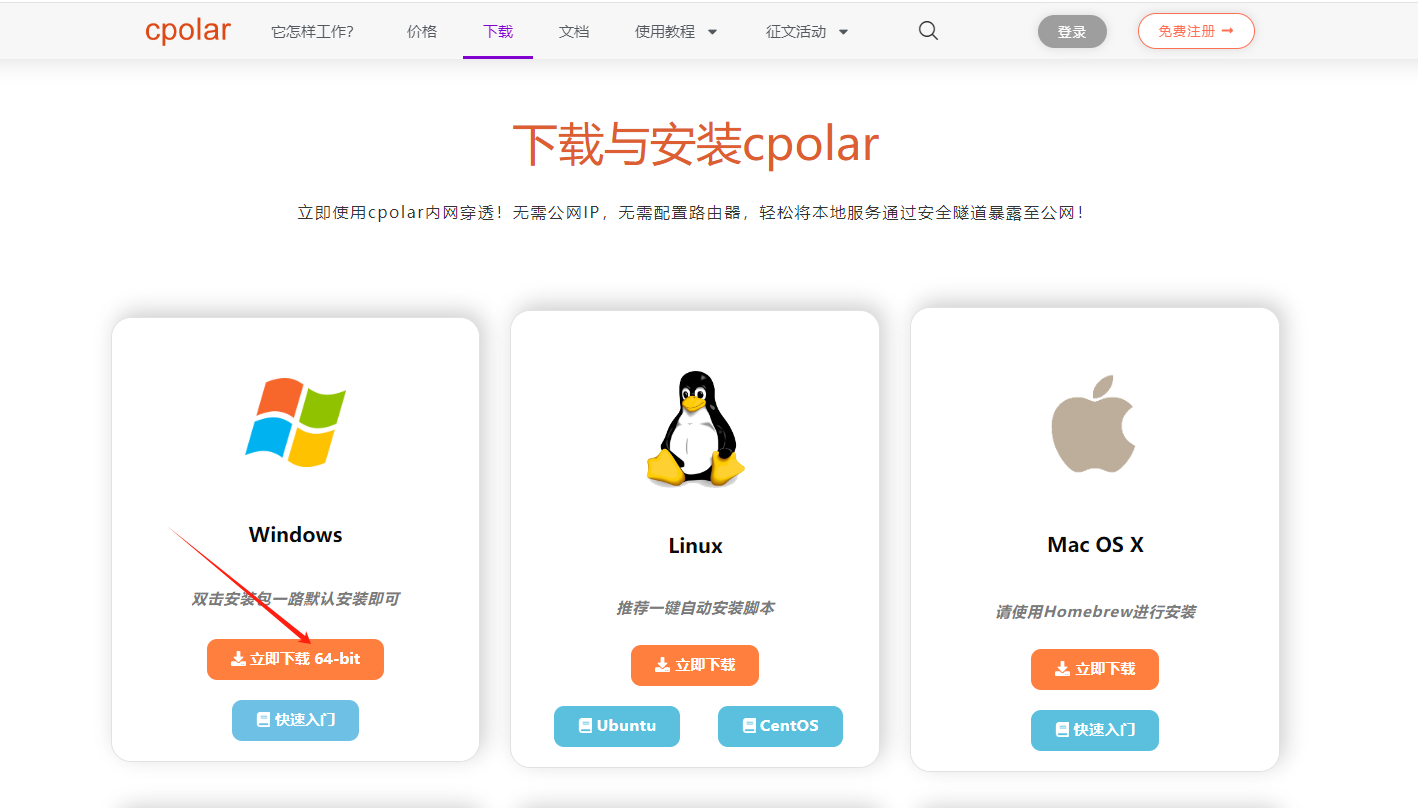

登录成功后,点击下载Cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

Cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到Cpolar web 配置界面,结下来在web 管理界面配置即可。

接下来配置一下 LobeChat 的公网地址,

登录后,点击左侧仪表盘的隧道管理——创建隧道,

创建一个 LobeChat 的公网http地址隧道

-

隧道名称:可自定义命名,注意不要与已有的隧道名称重复

-

协议:选择http

-

本地地址:3010 (本地访问的地址)

-

域名类型:选择随机域名

-

地区:选择China Top

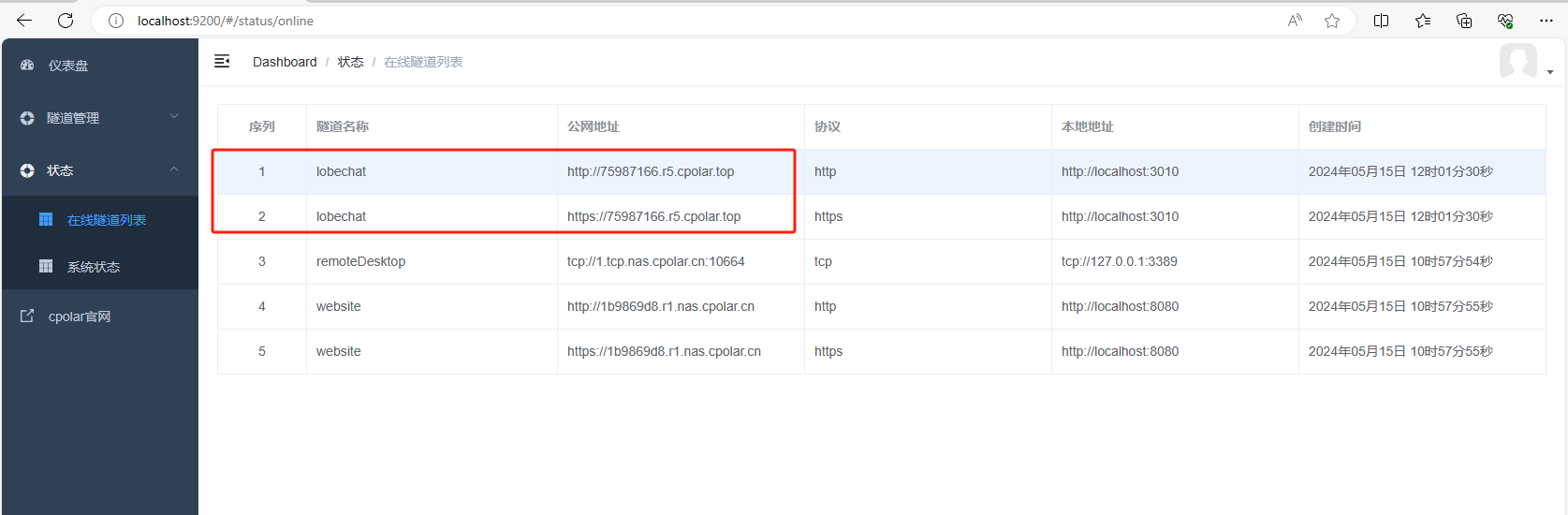

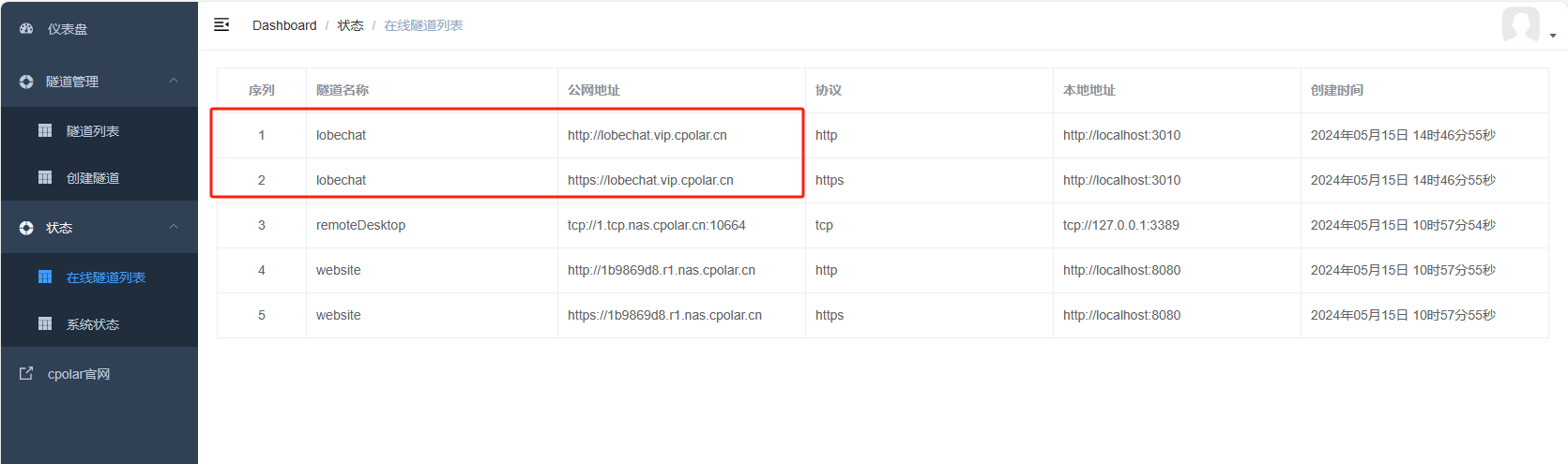

隧道创建成功后,点击左侧的状态——在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https

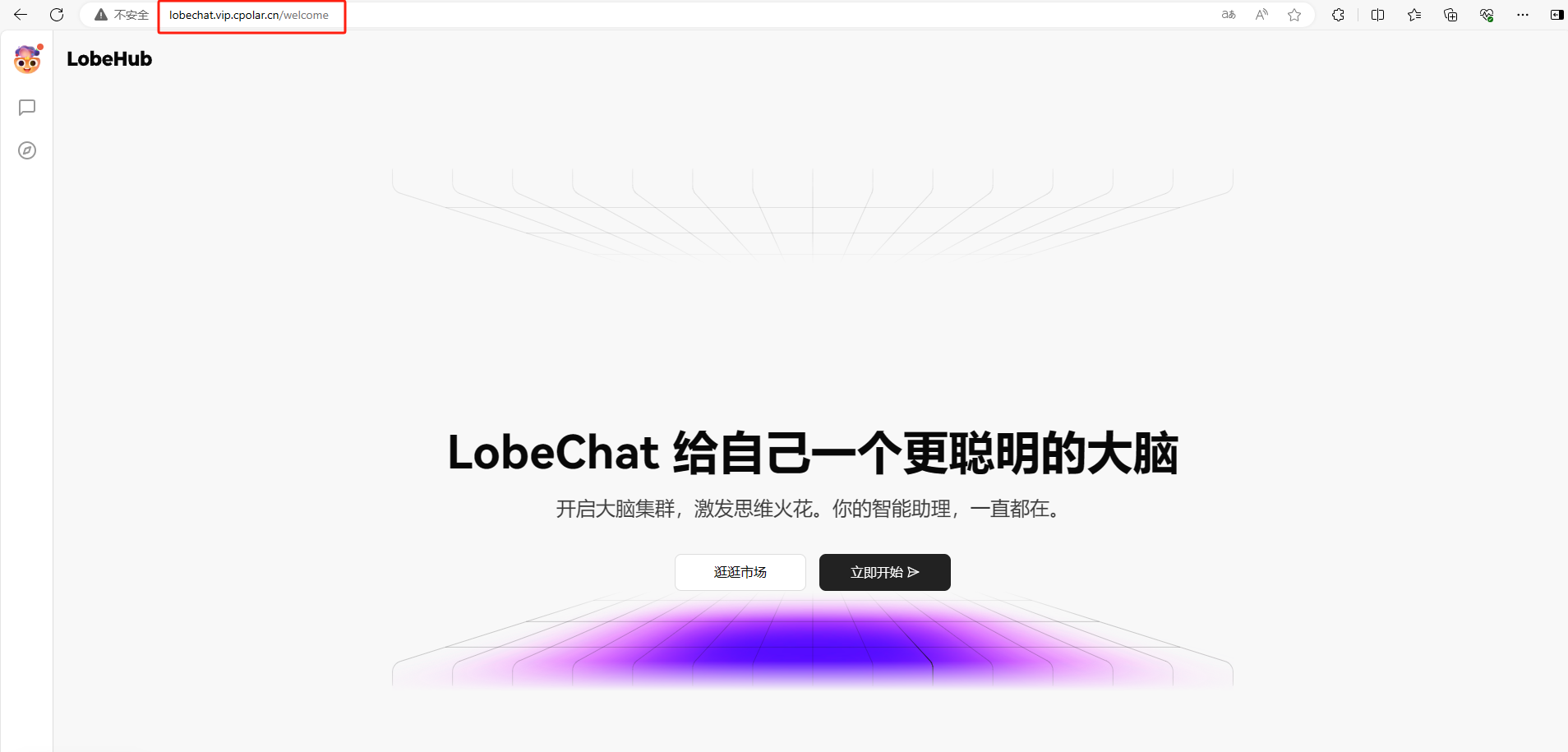

使用上面的Cpolar https公网地址,在手机或任意设备的浏览器进行登录访问,即可成功看到 LobeChat 界面,这样一个公网地址且可以远程访问就创建好了,使用了Cpolar的公网域名,无需自己购买云服务器,即可到公网访问 LobeChat 了!

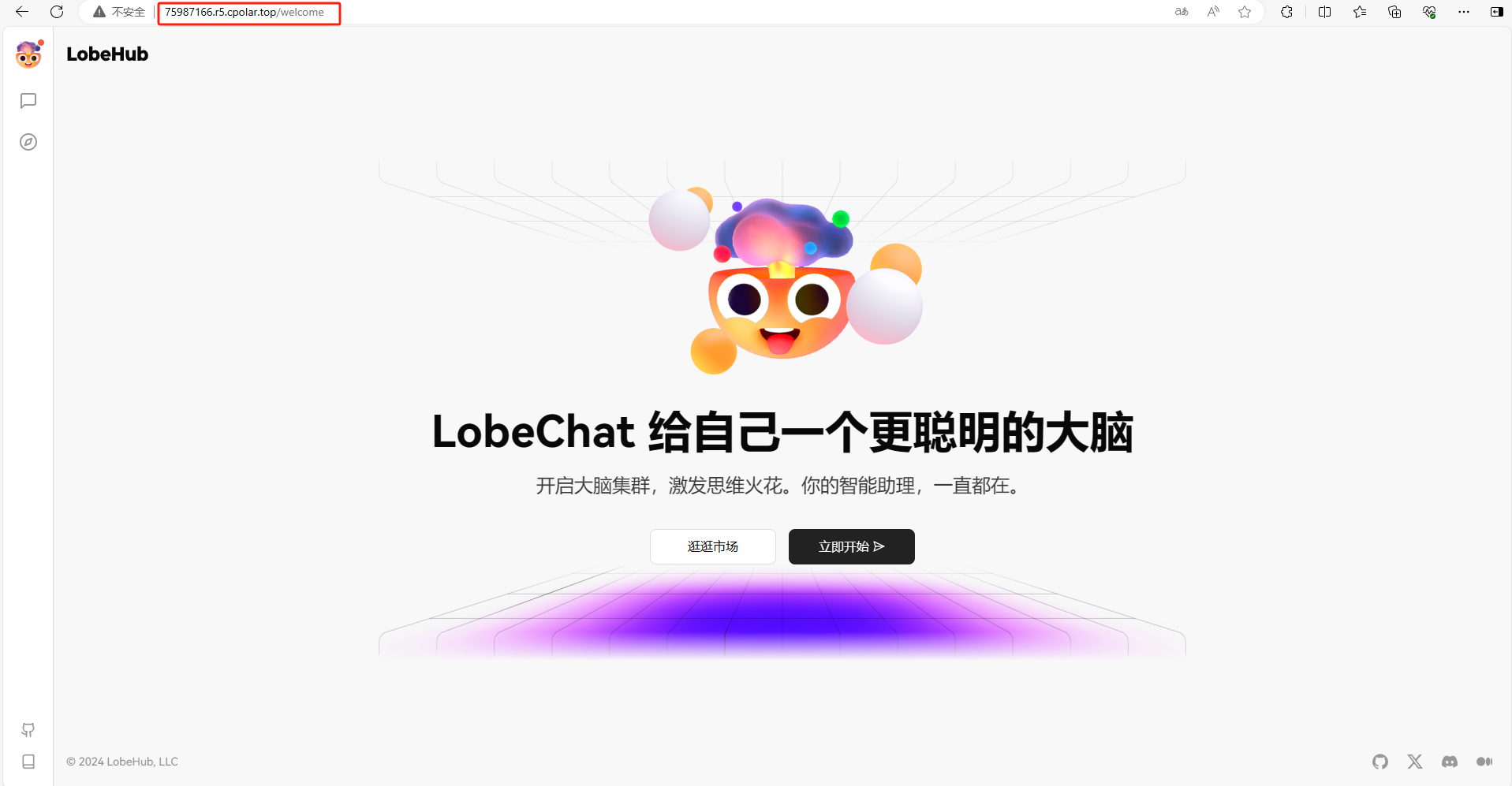

5. 实现公网访问LobeChat

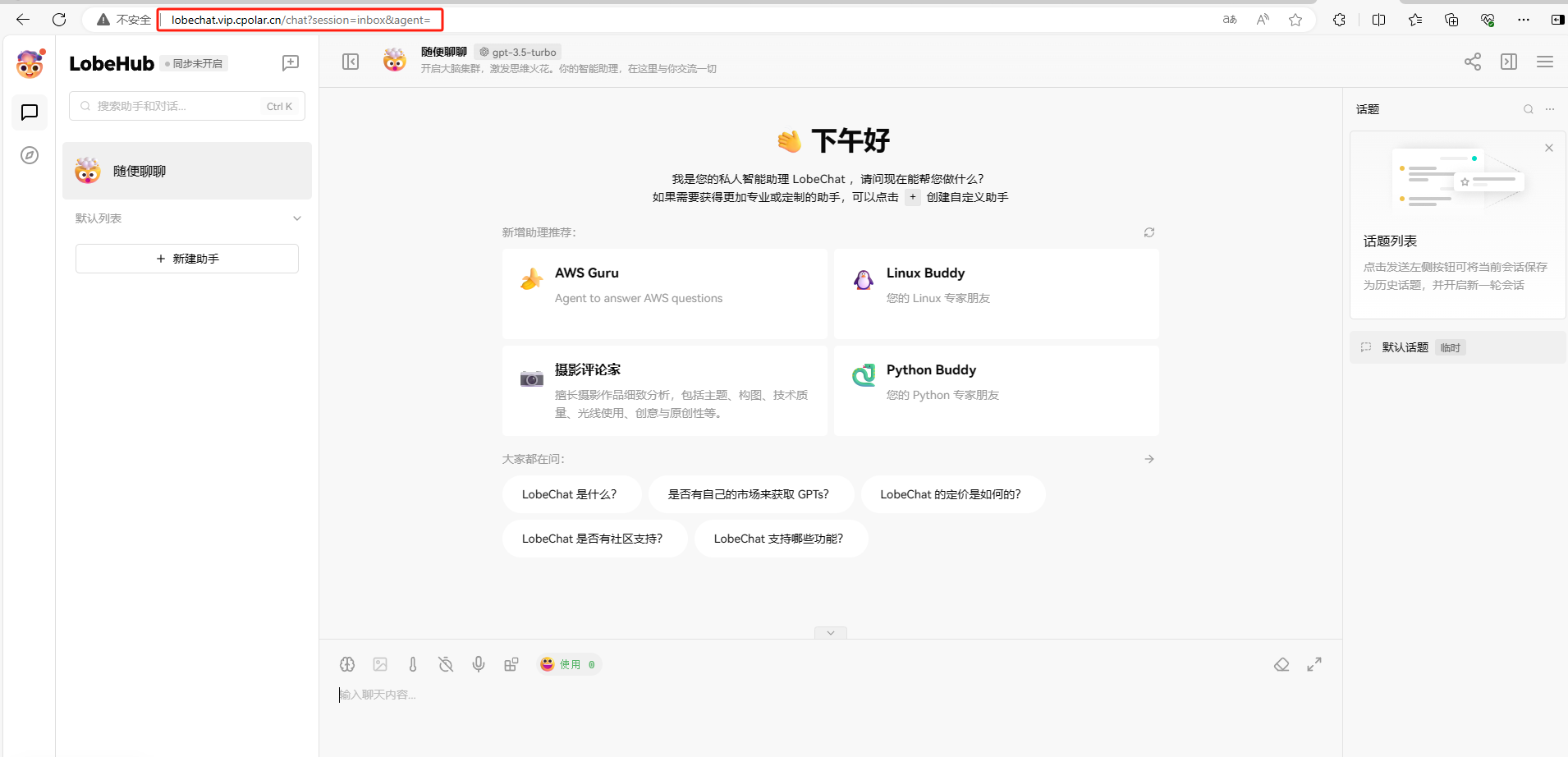

我们用刚才cpolar生成的公网地址,打开一个新的浏览器复制粘贴,可以看到进入到了LobeChat项目管理界面,然后选择Llama3.1大模型就可以进行在公网来使用了。

小结

如果我们需要长期进行团队协作的话,由于刚才创建的是随机的地址,24小时会发生变化。另外它的网址是由随机字符生成,不容易记忆。如果想把域名变成固定的二级子域名,并且不想每次都重新创建隧道来访问LobeChat,我们可以选择创建一个固定的http地址来解决这个问题。

6. 固定LobeChat公网地址

我们接下来为其配置固定的HTTP端口地址,该地址不会变化,方便分享给别人长期查看你的博客,而无需每天重复修改服务器地址。

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留,保留成功后复制保留的二级子域名名称。

保留成功后复制保留成功的二级子域名的名称

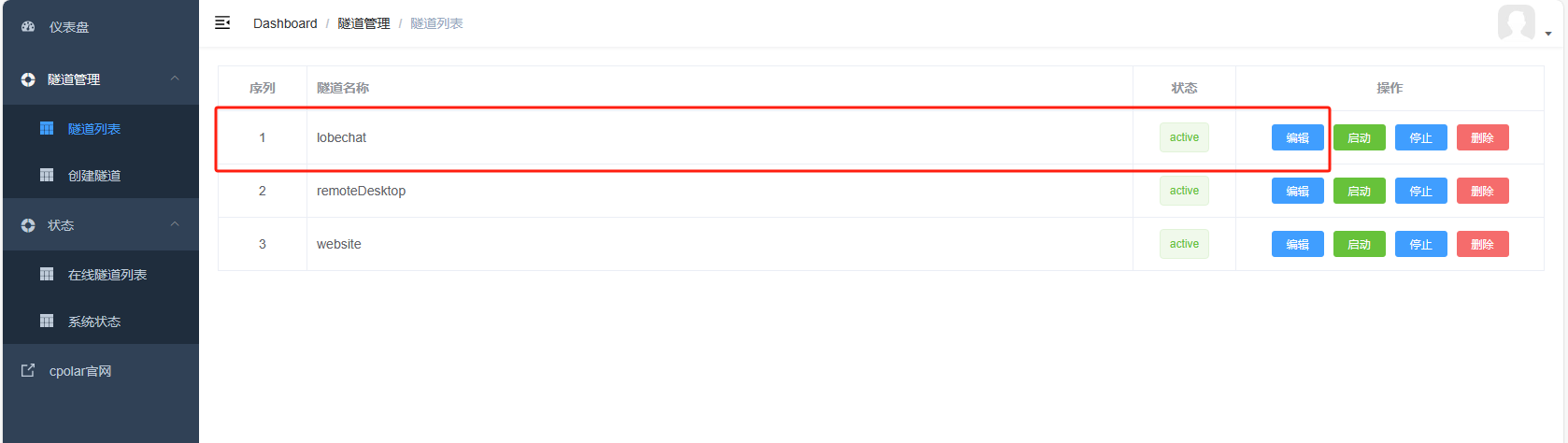

返回登录Cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道,点击右侧的编辑

修改隧道信息,将保留成功的二级子域名配置到隧道中

-

域名类型:选择二级子域名

-

Sub Domain:填写保留成功的二级子域名

点击更新(注意,点击一次更新即可,不需要重复提交)

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名

最后,我们使用固定的公网https地址在任何浏览器打开访问,可以看到访问LobeChat成功了这样一个固定且永久不变的公网地址就设置好了,然后选择一下Llama3.1大模型就可以。

希望这篇文章对你有所帮助!安装和配置 Llama3.1 以及通过 LobeChat 实现公网远程访问的过程虽然有些复杂,但只要按照本文的指引一步步来,你一定能够成功搭建起自己的 AI 环境。