1. 什么是爬虫?

爬虫(Web Crawler)是一种通过编写程序自动访问并提取互联网上数据的技术。爬虫可以帮助我们在浏览网页时自动收集和保存一些有用的数据,例如图片、视频和文本信息。简单来说,爬虫就是自动化的浏览器。

例如:

- 在浏览一些美丽的自然风景图片时,想要保存这些图片作为桌面壁纸。

- 在浏览到一些行业的统计数据时,希望能保存下来进行分析。

- 在发现一些有趣的新闻文章时,想要保存并方便日后阅读。

- 在找到一些有用的教程视频时,希望下载并保存以便离线学习。

恭喜你,如果你有以上需求,本课程将非常适合你。因为爬虫就是通过编写程序来自动化获取互联网上的资源(如图片、音频、视频和数据)。

2. 爬虫和Python

爬虫一定要用Python吗?当然不!Java、C等语言也可以实现爬虫。请记住,编程语言只是工具,抓到数据才是你的目的。就像吃饭一样,可以用叉子,也可以用筷子,最终的结果都是你能吃到饭。

那为什么大多数人喜欢用Python呢?答案很简单:因为Python写爬虫实在是太方便了。你可以想象一下,为什么吃米饭不用刀叉而用筷子?因为简单,好用!

Python是众多编程语言中,初学者上手最快,语法最简单的。更重要的是,Python有非常多适合爬虫的第三方支持库。就好比,你用筷子吃饭,我还送你一个私人厨师,帮你把饭菜都准备好。这样吃饭是不是更爽了,更容易了?

所以,选择Python来写爬虫,就像选择了一条康庄大道,省时省力,还能事半功倍。

3. 爬虫是否合法?

首先,爬虫在法律上是不被禁止的。也就是说,法律允许爬虫的存在。但是,爬虫也具有违法的风险。就像菜刀一样,法律允许菜刀的存在,但如果你用它来伤人,那就违反了法律。正如王欣所说,技术是无罪的,关键在于你用它来做什么。例如,有些人利用爬虫结合黑客技术,每秒钟对着bilibili发送大量请求,这显然是不被允许的。

爬虫分为善意的爬虫和恶意的爬虫:

- 善意的爬虫:不破坏被爬取网站的资源(正常访问,频率适当,不窃取用户隐私)。

- 恶意的爬虫:影响网站的正常运营(如抢票、秒杀,疯狂获取网站资源导致网站宕机)。

真实案例

全国首例短视频爬虫案宣判:涉爬虫的刑法案件及刑事法律规制: 全国首例短视频爬虫案宣判:涉爬虫的刑法案件及刑事法律规制 - 21经济网

** 建议**

为了避免法律风险,我们在编写和使用爬虫时应当遵循以下原则:

- 遵守法律法规:了解和遵守目标网站所在国家和地区的法律法规。

- 尊重网站的robots.txt协议:了解哪些内容允许爬取,哪些内容不允许。

- 控制爬虫的访问频率:避免对网站服务器造成负担,通常可以设置延时和频率限制。

- 不窃取敏感信息:不要爬取和传播涉及用户隐私和商业机密的数据。

综上所述,我们应当安分守己,时常优化自己的爬虫程序,避免干扰网站的正常运行。在使用爬取到的数据时,发现涉及用户隐私和商业机密等敏感内容时,一定要及时终止爬取和传播。

4. 爬虫的矛与盾

在网络世界里,爬虫和反爬虫就像是一场永无止境的猫捉老鼠游戏。网站不希望自己的数据被随意抓取,于是他们制定了各种反爬机制。而聪明的程序员们,则不断开发新的反反爬策略来绕过这些障碍。就像武林高手之间的过招,招式不断升级。

4.1 反爬机制

网站为了防止爬虫程序抓取数据,会使用多种策略和技术手段,比如:

- 限制访问频率:如果你的爬虫访问速度过快,网站会怀疑你不是人类,从而封锁你的IP地址。

- 检测用户行为:网站会检查你的请求是否像人类用户一样,比如是否有鼠标移动、点击等行为。

- 验证码:强制要求输入验证码,以确认访问者是人类而不是爬虫。

4.2 反反爬策略

而程序员们为了获取数据,也会使用各种策略和技术手段来绕过这些反爬机制,比如:

- 使用代理IP:通过不断更换IP地址来避免被封锁。

- 模拟用户行为:让爬虫程序模拟人类的浏览行为,比如随机点击、移动鼠标等。

- 破解验证码:使用机器学习算法自动识别和输入验证码。

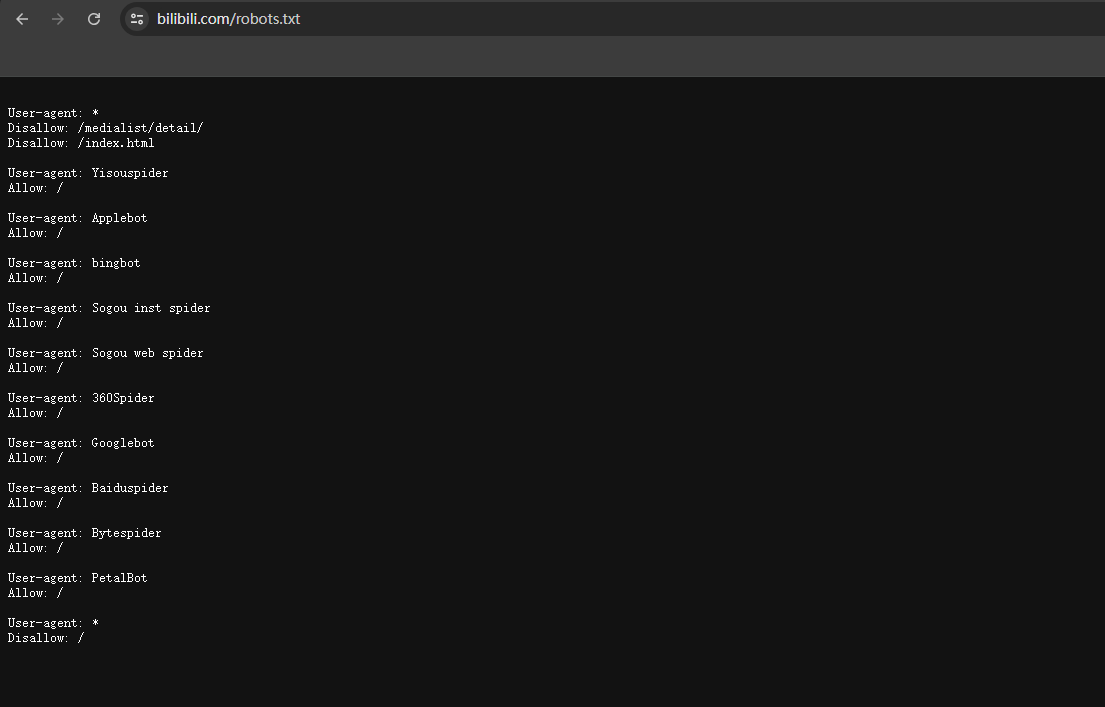

4.3 robots.txt协议

这就像一份网络世界的“君子协议”。网站在自己的根目录下放置一份名为robots.txt的文件,告诉爬虫哪些数据可以抓取,哪些数据不能抓取。遵守这个协议的爬虫是“君子”,会按规矩办事;不遵守这个协议的爬虫则是“侠客”,会寻找其他方式获取数据。

示例:

- 君子爬虫:先访问https://www.example.com/robots.txt,看网站允许爬取哪些内容,然后按照规则抓取。

- 侠客爬虫:直接绕过robots.txt,利用各种反反爬手段抓取数据。

无论你是选择做“君子”还是“侠客”,都要记住,合理使用爬虫技术,不滥用资源,不侵犯他人隐私和商业机密,才能成为一名负责任的爬虫开发者。