【对比学习,Contrastive Learning】是一种自监督学习方法,通过将视觉表示拉近相似样本、推远不相似样本来学习特征。它不依赖于标签,利用数据增强和负样本采样来提升特征的区分性。对比学习在提高模型对不同数据变化的鲁棒性方面表现出色,有助于在有限的标注数据下训练出更好的模型。此外,它在多个视觉任务中,如分类、检测和分割等,都展现了显著的性能提升,对推动深度学习模型的泛化能力和应用范围具有重要意义。

为了帮助大家全面掌握【对比学习】的方法并寻找创新点,本文总结了最近两年【对比学习】相关的26篇顶会顶刊研究成果,这些论文、来源、论文的代码都整理好了,希望能给各位的学术研究提供新的思路。

需要的同学扫码添加我

回复“对比学习26”即可全部领取

任意三篇论文解析

1、Debiased Contrastive Learning for Sequential Recommendation

方法

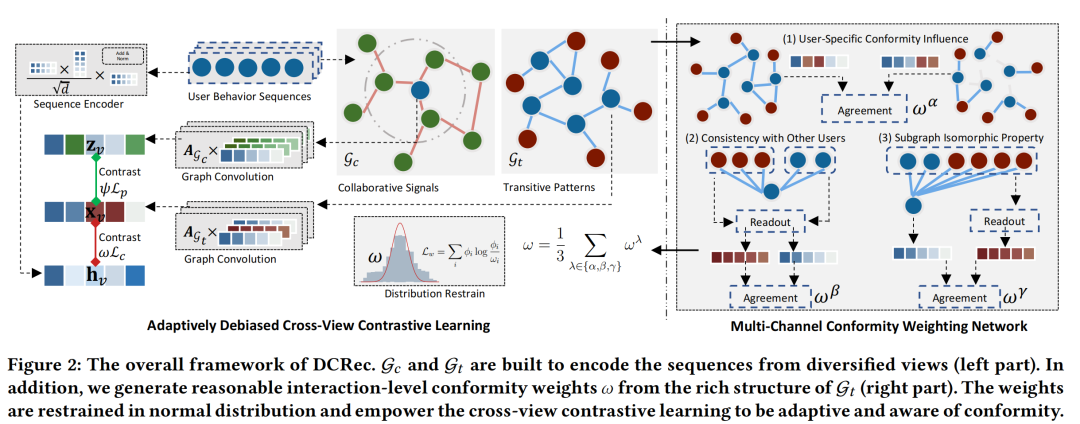

- 本文提出了一种新的去偏对比学习方法(DCRec),旨在解决序列推荐系统中的流行度偏差问题。

- DCRec通过自适应的一致性感知增强来统一序列模式编码和全局协同关系建模。

- 利用Transformer对用户行为序列进行编码,捕获用户兴趣的时序变化。

- 构建了两种图神经网络(GNN):物品转换图和物品共现图,以捕获物品间的转换关系和用户间的协同信号。

- 提出了多通道一致性加权网络(CWNet),从三个语义通道学习用户行为的一致性程度。

- 通过对比学习,在不同视图间进行自监督信号的提取,使用InfoNCE损失函数进行嵌入对比。

- 在训练阶段,模型使用交叉熵损失和对比学习损失进行多任务优化。

创新点

- 去偏对比学习框架:DCRec首次提出在序列推荐中使用去偏对比学习框架,以减少数据增强中的流行度偏差。

- 一致性感知增强:通过自适应的数据增强,结合用户行为的一致性权重,使得模型能够更加关注用户的真实兴趣而非从众行为。

- 多通道一致性加权网络(CWNet):创新性地从用户特定影响、与其他用户的一致性、子图同构性质三个维度来估计交互的一致性程度。

- 跨视图对比学习:模型不仅在用户维度上进行对比学习,还在物品维度上进行对比,以提取高质量的物品嵌入。

- 自适应的对比学习:根据用户的一致性程度动态调整对比学习的正则化强度,从而更有效地分离用户兴趣和从众行为。

- 多任务训练目标:结合了推荐任务损失和自监督学习任务损失,通过多任务学习框架进行优化。

2、Dynamic Conceptional Contrastive Learning for Generalized Category Discovery

方法:

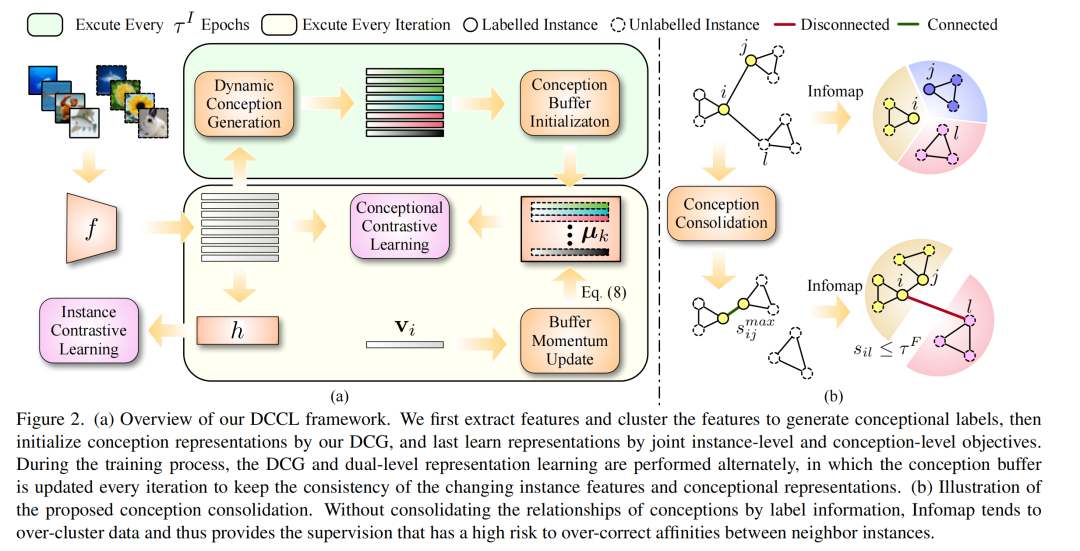

- 提出了一种新的框架,Dynamic Conceptional Contrastive Learning (DCCL),用于解决广义类别发现(Generalized Category Discovery, GCD)问题,即在部分标记的数据中自动聚类。

- DCCL利用自监督学习来学习未标记数据的区分性表示,同时考虑了同一概念下实例间的关系(例如类别、超类和子类)。

- 包括两个主要步骤:动态概念生成(Dynamic Conception Generation, DCG)和双层对比学习(Dual-level Contrastive Learning, DCL)。

- DCG基于无超参数的聚类方法,通过半监督概念巩固来动态生成概念表示。

- DCL使用概念级别和实例级别的对比学习目标进行优化,并维护动态记忆以确保与最新的概念进行比较。

- 通过交替执行DCG和DCL直到模型收敛。

创新点:

- 动态概念生成(DCG):提出了一种新颖的动态概念生成和更新机制,确保一致的概念学习,从而促进DCCL的优化。

- 双层对比学习(DCL):在概念级别和实例级别上进行对比学习,通过动态记忆来保持与最新概念的比较,这有助于学习更具有区分性的表示。

- 半监督概念巩固:一种新颖的方法,通过将标记数据的监督信息整合到网络中,构建相似性网络,然后执行Infomap聚类算法来获取概念标签分配。

- 概念级别动量更新:提出了一种动量更新机制,用于更新概念表示,显著减少存储成本,并保持训练过程中概念表示的一致性。

- 分散损失(Dispersion Loss):提出了一种新的损失函数,用于进一步推动不同概念表示之间的距离,从而显式地鼓励学习具有较大概念间边界的表示。

需要的同学扫码添加我

回复“对比学习26”即可全部领取

3、Temporal Knowledge Graph Reasoning with Historical Contrastive Learning

方法:

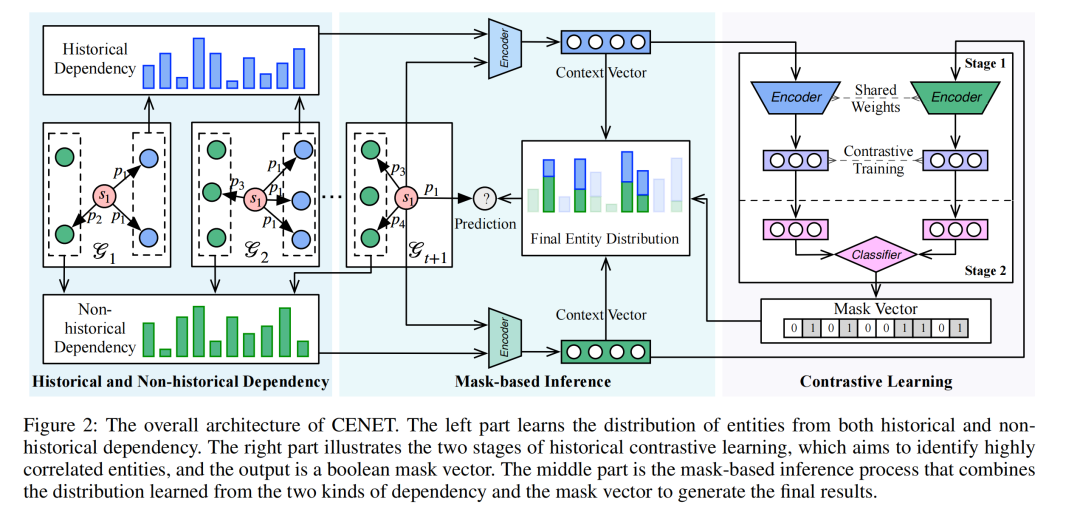

- 提出了一个新的事件预测模型,名为 Contrastive Event Network (CENET),基于历史对比学习的新框架。

- CENET 学习历史和非历史依赖性,以区分与给定查询最匹配的潜在实体。

- 通过对比学习训练查询的表示,以调查当前时刻更多地依赖于历史事件还是非历史事件。

- 使用二元分类器输出布尔掩码来指示搜索空间中的相关实体。

- 在推理过程中,CENET 使用基于掩码的策略来生成最终结果。

创新点:

- 历史对比学习框架:CENET 是首个将对比学习应用于知识图谱推理的模型,通过训练查询的对比表示来识别高度相关的实体。

- 同时考虑历史和非历史依赖性:与现有方法不同,CENET 同时考虑了与实体在当前查询中相关的历史事件和非历史事件。

- 基于复制机制的评分策略:首次采用基于复制机制的评分策略来模拟历史和非历史事件的依赖性。

- 查询的分类学习:CENET 自然地使用监督对比学习来训练两类查询的表示,进一步帮助训练分类器,其输出是用于识别应更多关注的实体类型的布尔值。

- 基于掩码的推理过程:在推理过程中,结合了历史和非历史依赖性的分布,并根据分类结果使用基于掩码的策略来考虑高度相关的实体。

- 显著的性能提升:在五个基准图上的评估结果显示,CENET 在大多数指标上显著优于所有现有方法,在基于事件的数据集上至少实现了比以前最好基线提高8.3%的Hits@1相对改进。

需要的同学扫码添加我

回复“对比学习26”即可全部领取